完整性采集和选择性采集是目前比较常用的网络资源采集方式,它们各有优缺点,为了弥补其各自的不足,可以实现两种采集方式的优势互补,采用融合二者优点的混合型采集方式,在对选定的政府网站中所有网页进行完整性采集的同时,通过人工干预的方式对网页内容进行甄别,对其中有证据价值、历史价值、研究价值的重要网页,有选择性地进行深层次的频繁采集,这样既考虑到了政府网页采集面的广度,同时又照顾到了重要网页采集的深度。

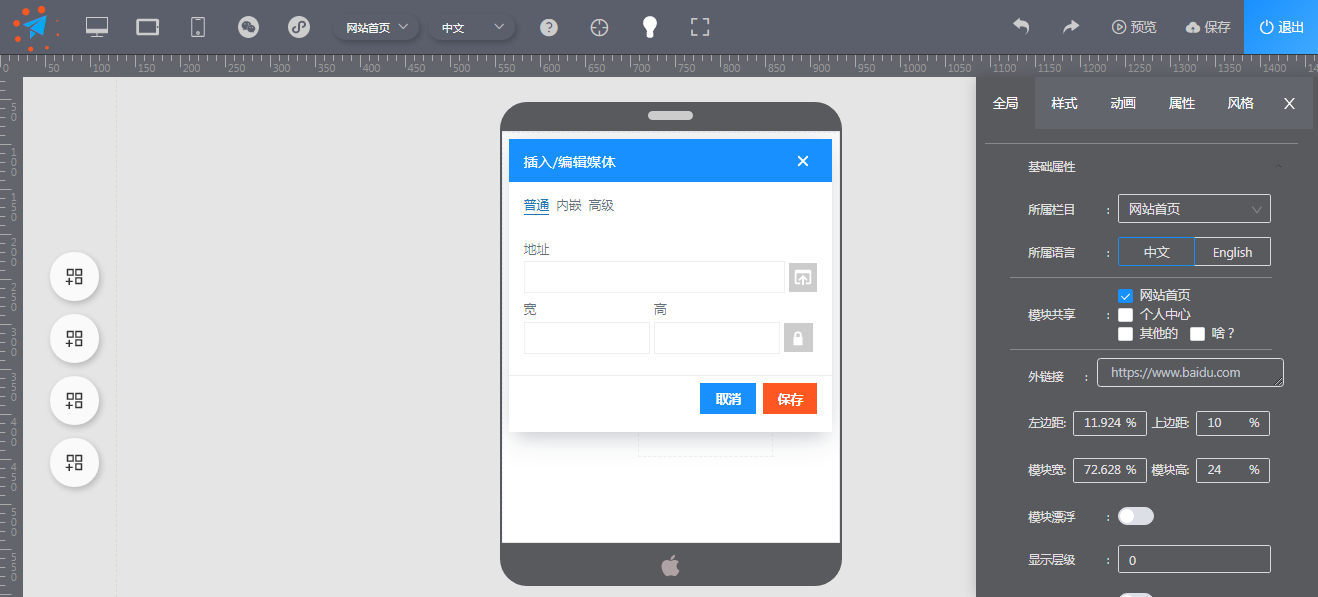

而网页的采集与捕获最终还需要依靠相应的网络爬虫工具来实现,目前面向网页存档的爬虫工具比较多,其中Heritrix、HTTrack最为常用,可利用这些工具来有针对性地完成对目标政府网站网页的自动批量在线采集。

没有更多内容。

490

490